robots-txt : Différence entre versions

(→Articles Vulgum Techus) |

|||

| Ligne 1 : | Ligne 1 : | ||

[[Catégorie:Normes]] | [[Catégorie:Normes]] | ||

[[Catégorie:Sites Internet]] | [[Catégorie:Sites Internet]] | ||

| − | '''[[Lien court]]''' vers cette page : | + | '''[[Lien court]]''' vers cette page : https://vt.cx/rt |

| − | '''[[QR code]]''' vers cette page : | + | '''[[QR code]]''' vers cette page : https://vt.cx/rt.qr |

| − | + | ||

<html> | <html> | ||

| − | <script | + | <script async src="//pagead2.googlesyndication.com/pagead/js/adsbygoogle.js"></script> |

| − | + | <!-- VT2 --> | |

| − | + | <ins class="adsbygoogle" | |

| − | + | style="display:inline-block;width:468px;height:60px" | |

| − | + | data-ad-client="ca-pub-3341840374417340" | |

| − | + | data-ad-slot="6349432125"></ins> | |

| − | + | <script> | |

| − | </ | + | (adsbygoogle = window.adsbygoogle || []).push({}); |

| − | <script | + | </script></html> |

| − | + | ||

| − | </script> | + | |

| − | </html> | + | |

<br/> | <br/> | ||

= Présentation = | = Présentation = | ||

| − | Le | + | Le document texte robots.txt placé à la racine des '''[[sites Internet]]''' servent à indiquer les dossiers dont on ne souhaite pas l'indexation par les moteurs de recherches. Il ne faut pas compter sur '''robots.txt''' pour assurer une quelconque confidentialité d'un contenu placé en ligne car de nombreux '''[[bots]]''' et '''[[moteurs de recherche]]''' ne tiennent pas compte. Ainsi '''[[Google]]''' indexe les contenu, malgré ce qu'il indique à https://support.google.com/webmasters/answer/6062608?hl=fr, comme l'atteste la copie d'écran ci-dessous. Pour une bonne sécurisation de dossiers sensibles, il est donc préférable de recourir à la protections par '''[[mots de passe]]''' très facilement réalisable sur tout '''[[site]]''' grâce à '''[[htaccess|.htaccess]]'''. |

<br/><br/> | <br/><br/> | ||

[[Fichier:robots-txt UPU 141214.jpg]]<br/> | [[Fichier:robots-txt UPU 141214.jpg]]<br/> | ||

| Ligne 27 : | Ligne 23 : | ||

= Liens utiles = | = Liens utiles = | ||

| − | * [ | + | * [https://robots-txt.com robots-txt.com] '''[[Manuel]]''' d'implémentation |

| − | * [https://support.google.com/webmasters/answer/6062608?hl=fr support.google.com] | + | * [https://support.google.com/webmasters/answer/6062608?hl=fr support.google.com] robots.txt et Google |

| − | * [ | + | * [https://www.upu.int/robots.txt upu.int] robots.txt du site upu.int |

| + | |||

| + | = Articles externes = | ||

| + | * [https://www.numerama.com/tech/530234-google-a-un-plan-pour-que-le-web-soit-mieux-indexe.html Numérama - 02/07/19] Google a un plan pour que le web soit mieux indexé | ||

| + | * [https://www.nextinpact.com/news/88732-google-met-a-jour-son-outil-test-fichier-robots-txt.htm NEXT INpact - 16/07/14] Google met à jour son outil de test du fichier Robots.txt | ||

| + | * [https://www.nextinpact.com/news/88552-20-ans-robots-txt-google-se-protege-terminator-dautres-samusent.htm NEXT INpact - 05/07/14] 20 ans de robots.txt : Google se protège des Terminator, d'autres s'amusent | ||

= Articles Vulgum Techus = | = Articles Vulgum Techus = | ||

| Ligne 35 : | Ligne 36 : | ||

* [[robots.txt pour MediaWiki]] | * [[robots.txt pour MediaWiki]] | ||

* [[robots.txt de Le bon coin]] | * [[robots.txt de Le bon coin]] | ||

| − | + | * [[Google]] | |

| − | + | ||

| − | * | + | |

| − | + | ||

= Commentaires = | = Commentaires = | ||

Version du 2 juillet 2019 à 12:24

Lien court vers cette page : https://vt.cx/rt QR code vers cette page : https://vt.cx/rt.qr

Présentation

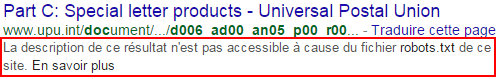

Le document texte robots.txt placé à la racine des sites Internet servent à indiquer les dossiers dont on ne souhaite pas l'indexation par les moteurs de recherches. Il ne faut pas compter sur robots.txt pour assurer une quelconque confidentialité d'un contenu placé en ligne car de nombreux bots et moteurs de recherche ne tiennent pas compte. Ainsi Google indexe les contenu, malgré ce qu'il indique à https://support.google.com/webmasters/answer/6062608?hl=fr, comme l'atteste la copie d'écran ci-dessous. Pour une bonne sécurisation de dossiers sensibles, il est donc préférable de recourir à la protections par mots de passe très facilement réalisable sur tout site grâce à .htaccess.

Exemple d'un document dont l'UPU ne voulait pas l'indexation par un moteur de recherche

Liens utiles

- robots-txt.com Manuel d'implémentation

- support.google.com robots.txt et Google

- upu.int robots.txt du site upu.int

Articles externes

- Numérama - 02/07/19 Google a un plan pour que le web soit mieux indexé

- NEXT INpact - 16/07/14 Google met à jour son outil de test du fichier Robots.txt

- NEXT INpact - 05/07/14 20 ans de robots.txt : Google se protège des Terminator, d'autres s'amusent